全好意思TOP 5的机器学习博士窘态发帖自曝,我方实验室里H100数量是0!这也引起了ML社区的全球网友大究诘。明显,比拟普林斯顿、哈佛这样动辄三四百块H100的GPU大户,更常见的是GPU枯竭的「穷东说念主」。归并个实验室的博士,致使常常会出现需要争抢GPU的情况。

全好意思TOP 5高校的机器学习博士,实验室却连一块H100都莫得?

最近,这位网友在reddit上发的这个帖子,坐窝激发了社区大究诘——

全球发现,普林斯顿、哈佛这样的「GPU权门」,手上的H100至少以三四百块打底,但是绝大大量ML博士,却连一块H100都用不上……

不同学校、机构之间的GPU「贫富差距」,果然照旧到了如斯悬殊的地步?

大部分实验室,比斯坦福还差多了

两个月前,AI教母李飞飞曾在采访中暗意,斯坦福的天然言语处理(NLP)小组只消64块A100 GPU。

面临学术界如斯匮乏的AI资源,李飞飞可谓是窘态疾首。

而这位发帖的网友也暗意,我方在攻读博士学位时期(全好意思名次前五的学校),计较资源是一个主要的瓶颈。

如果能有更多高性能的GPU,计较时刻会显耀裁减,筹商进程也会快好多。

是以,他的实验室里到底有若干H100呢?谜底是——0。

他向网友们发动身问:你们实验室里都有若干GPU?能从亚马逊、英伟达那边拿到额外的算力赞助吗?

年青的筹商者们纷繁自曝我方所在学校或公司的GPU情况,浮现出的事实,让通盘东说念主大为诧异。

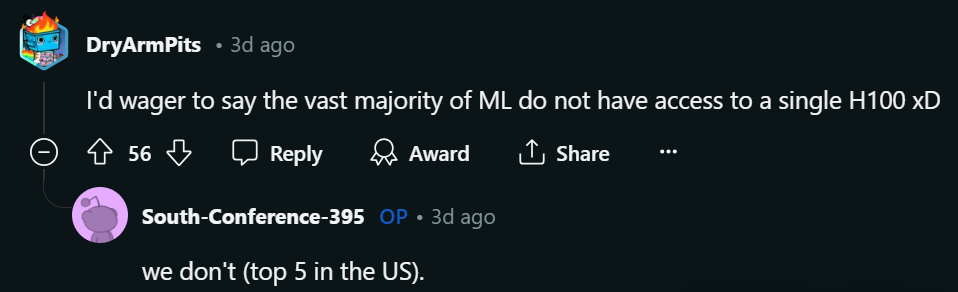

1张2080Ti+1张3090,已是沿途

一位似乎是亚洲的网友暗意,诚然我方的筹商地方是计较机视觉(CV)并不是机器学习,但在2019年刚运转时,只大要使用一块2080 Ti显卡。

2021年,有契机使用一台配备V100和RTX 8000显卡的奇迹器。

2022年,获取了使用一块3090显卡的权限。

2023年,大要使用另一个实验室的一组奇迹器,这些奇迹器包括12块2080 Ti、5块3090和8块A100显卡。同庚,还获取了一项计较资助,可以使用A100显卡三个月。

2024年,学校购买了一台配有8块H100显卡的奇迹器,并允许试用一个月。

此外,在2021年到2023年时期,也可以从一个土产货学术提供商那边按小时租用GPU。

除了2080 Ti和3090这两张显卡外,大大量这些资源都是分享的。

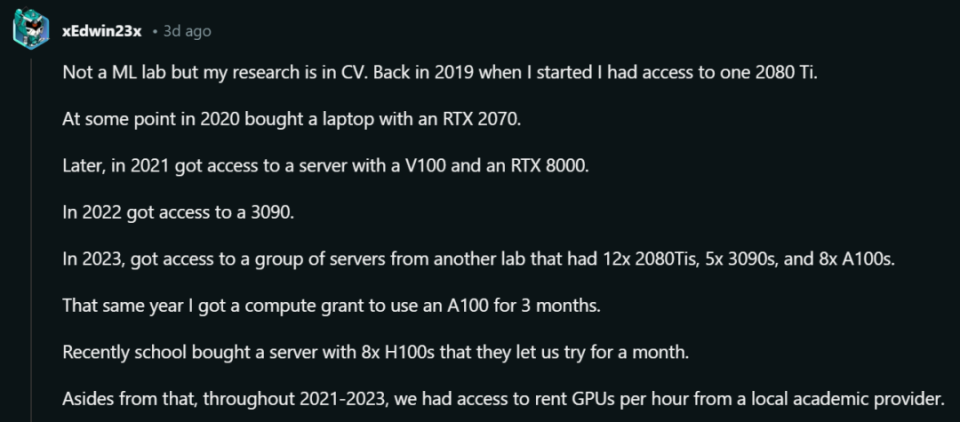

题主问:这里的「a」即是字面意旨上的「一个」么?

网友暗意,是的,即是这样否认……

有东说念主现身暗意,我方可太惨了:莫得显卡,莫得credits。因为所在大学无法提供匡助,只可让实习公司帮我方获取一些。

一位2022年底毕业的博士也自曝称,实验室专用的奇迹器共搭载了差未几30块GPU,其中每台奇迹器配有4张显卡。(由于购买时刻不同,性能也交加不皆)

不外,归并实验室里抢GPU的事情照旧时有发生。

对此,有网友回来说念,0 GPU很常见。

原理也相等不详:咱们并不需要开着法拉利来学车。而且在运转,机器学习的基础是线代、统计和编程,之后才是硬件经由的优化。

而GPU严重匮乏的问题,在我国高校的实验室内也很精深。

致使,有博主发帖称,某大学的课程竟要修业生自备算力开导。

五东说念主一组的学生,至少领有2块3090/4090,或者是1块40G A100,才能完成课程条目的LLM进修任务。

那么问题来了,为何高校我方不行多采购一些GPU呢?

至好「网瘾大爷」暗意,高校径直购买GPU相等不合算。LLM进修参数范围增大,需要的是多机多卡,以及让卡之间串联的相聚。

不仅有学习老本、还有爱戴老本,这对于高校来说插足之大。是以比较常见的方式是,去租用奇迹器。

清华计较机系在读博士孙恒冷落了相似的问题,卡可以买,但问题是,放在哪?

天然,有东说念主在负重前行,天然也有东说念主岁月静好。

比如底下这些学校,比拟起来就要「富庶」得多了。

「H100,咱们也就几百块吧」

有网友浮现,普林斯顿言语与智能筹商所(PLI)和哈佛Kempner筹商所领有最大的计较集群,分别配备了300块和400块H100 GPU。

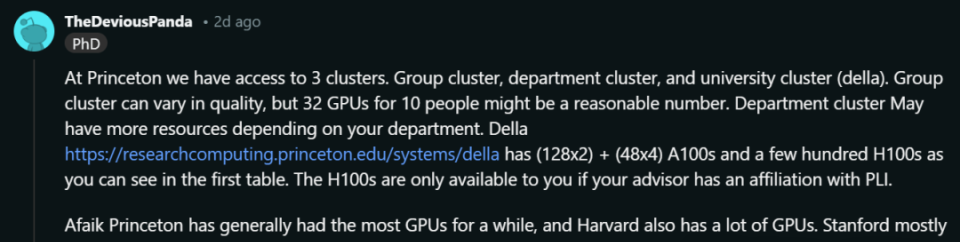

而这个信息,也得到了一位普林斯顿筹商者的佐证——

在普林斯顿,可以使用的集群有三种。

- 小组集群有所不同,但对于10个东说念主来说,32块GPU的分派很合理

- 部门集群的资源更多,不外也需要看具体的部门

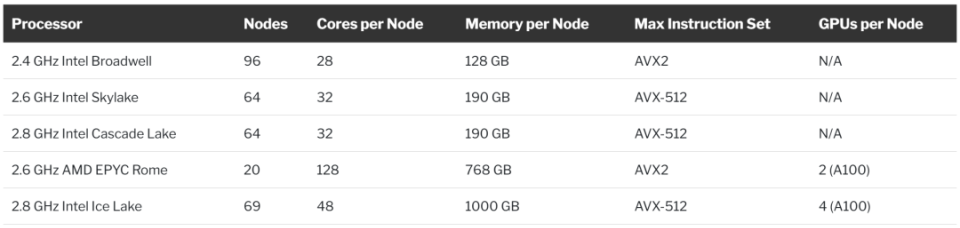

- 大学集群Della则领有(128x2)+(48x4)个A100和(96x8)个H100

总之,普林斯顿和哈佛都可以说是显卡大户。

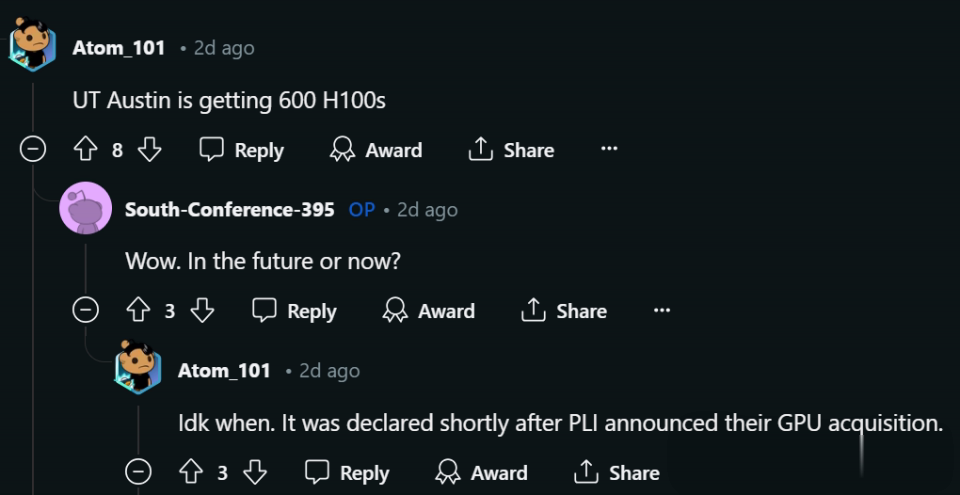

此外,也有网友爆料说,UT Austin领有600块H100。

蒙特利尔大学的博士生暗意,我方的实验室约莫有500块GPU,主淌若A100 40GB和80GB。

德国亚琛工业大学的网友暗意,学提供了一个包含52块GPU节点的计较集群,每个节点配备4块H100 GPU。

这些资源天然是通盘院系分享的,其他一些机构也能使用。

不外,即使是学生,每个月也会分派到一定的集群使用时刻。如果你需要更多的计较时刻,可以肯求不同范围的专用计较姿色。

「我相等可爱这个系统,大要使用它,对我来说是一次改变筹商进程的契机。」

对如斯充沛的算力,题主暗意相等齰舌。

另一位欧洲的网友也暗意,我方的实验室有约莫16块实验室专用的A100 GPU,何况还能通过几个不同的额外集群走访更多的GPU。

由于这些集群有好多用户,是以具体范围很难预计,但每个集群约莫每年提供12万GPU小时的计较时刻。

不外,逾越80GB的GPU内存需求是一个瓶颈。刻下来说,所有这个词能用的约为5块H100。

访佛的,这位网友所在的实验室,也相等富庶:

「咱们实验室有8块H100和8块L40S,专供5名博士生和3名博士后免费使用。」

临了,截取一些「凡尔赛」网友的发言。

比如,这位在云计较供应商使命的网友就暗意,这个帖子很兴致,因为我方竟不知说念H100是这样珍稀。

或者,从单元分不到显卡,那就干脆我方买一块。😂

紧俏的H100,为怎么此遑急

这背后最矜重的明星,莫过于它的H100 GPU了。

跟平日芯片不同的是,H100内的800亿个晶体管罗列在内核中,这些内核被调理为高速处理数据,而非生成图形。

确立于1993年的英伟达,押注并应用命的才调有一天将使我方的芯片在游戏以外阐扬价值,他们赌对了。

在进修LLM时,H100比前代A100快四倍,在回应用户教导时快30倍。对于急于进修LLM本质新任务的公司来说,性能上风至关遑急。

也恰是因此,全寰宇生成式AI的波澜,正在回荡为英伟达的实质收入。而H100的需求如斯之大,以至于许多客户不得不恭候六个月才能收成。

Nebius AI的IaaS本事产物司理Igor,探讨了H100、L4、L40、A100、V100这些最流行的芯片之间的互异,并详情了每种GPU模子发扬最好的使命负载。

谈到芯片之间的互异之前,遑急的是强调Transformer神经相聚和数值精度的一些关系属性。

数值精度的作用

如果莫得对FP8精度的硬件赞助,英伟达的H100、L4和L40不可能取得雄伟的得胜,这对于Transformer模子尤其遑急。

但是,是什么让对FP8的赞助如斯遑急呢?让咱们深刻了解一下。

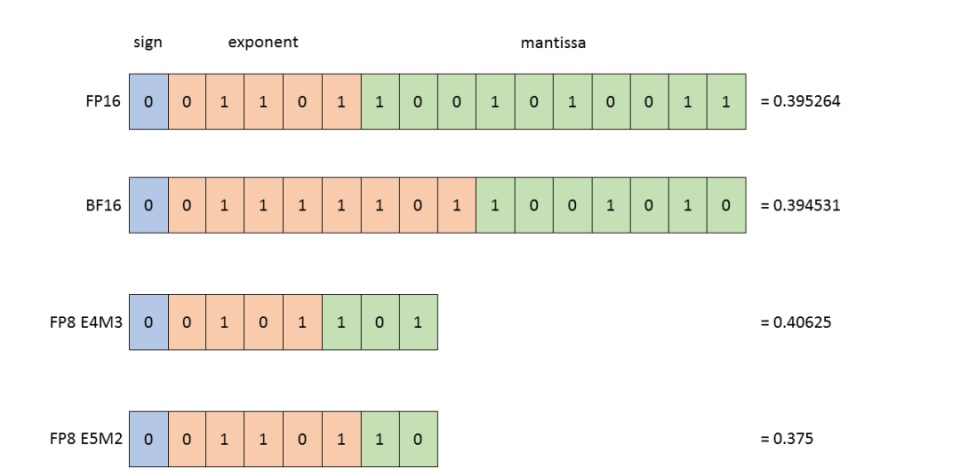

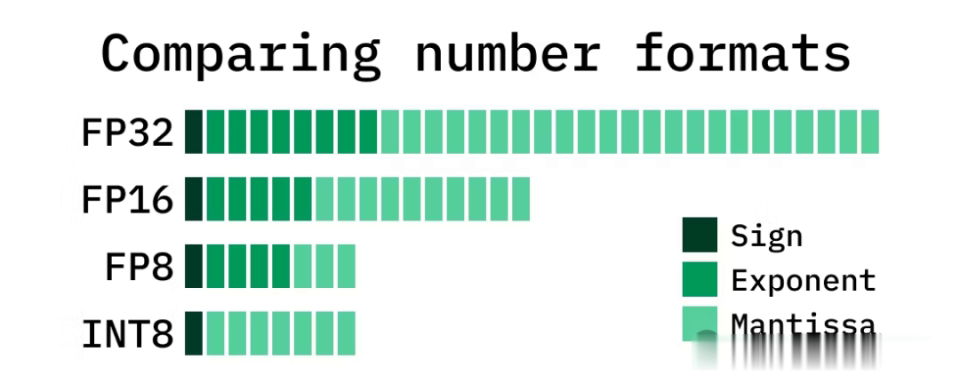

FP是「浮点」的缩写,它是对于模子存储在RAM中,并在其操作中使用的数字的精度。

最遑急的是,这些数字决定了模子输出的质料。

以下是一些重要的数字步地——

FP64,即双精度浮点步地,是一种每个数字占用64位内存的步地。

诚然这种步地未在机器学习中使用,但它在科学领域占有一隅之地。

FP32和FP16:长久以来,FP32是通盘深度学习计较的事实表率。

但是,数据科学家其后发现,将模子参数调理为FP16步地,可以减少内存浮滥并加速计较速率,而且似乎不会影响质料。

服从,FP16就成为了新的黄金表率。

TF32,亦然另一种至关遑急的步地。

在进入张量内核上处理FP32值的计较之前,这些值可以在驱动法子级别自动调理为TF32步地,而无需转变代码。

明显,TF32诚然略有不同,但能提供更快的计较速率。也即是说,可以通过模子在张量内核上解说FP32的方式进行编码。

INT8:这是一种整数步地,不触及浮点数。

进修后,模子参数可以调理为其他占用内存较少的类型,举例INT8。这种本事称为进修后量化,可以减少内存需求并加速推理速率。它为许多模子架构创造了遗迹,不外Transformer 是一个例外。

Transformer无法在进修后进行调理,以诽谤推理的硬件条目。量化感知进修等改革本事如确凿进修过程中提供了一种惩办步伐,但再行进修现存模子有可能老本腾贵,而且极具挑战性。

FP8:此步地惩办了上述问题,尤其是Transformer模子。

可以选择预进修的Transformer模子,将其参数调理为FP8步地,然后从A100切换到H100。

致使咱们可以在不进行调理的情况下作念到这少许,并仍然获取性能,仅仅因为H100速率更快。

借助FP8,只需约莫四分之一的显卡即可推断出具有相通性能和负载的相通模子。

另外,使用FP8进行搀和精度进修也很可以——这个过程会完成得更快,需要更少的RAM,何况在稍后的推理阶段不再需要调理,因为模子的参数可能照旧是FP8的参数。

ML、HPC和图形的重要GPU规格及性能基准

底下让咱们来究诘一下,GPU规格的演变偏抓杰出功能。

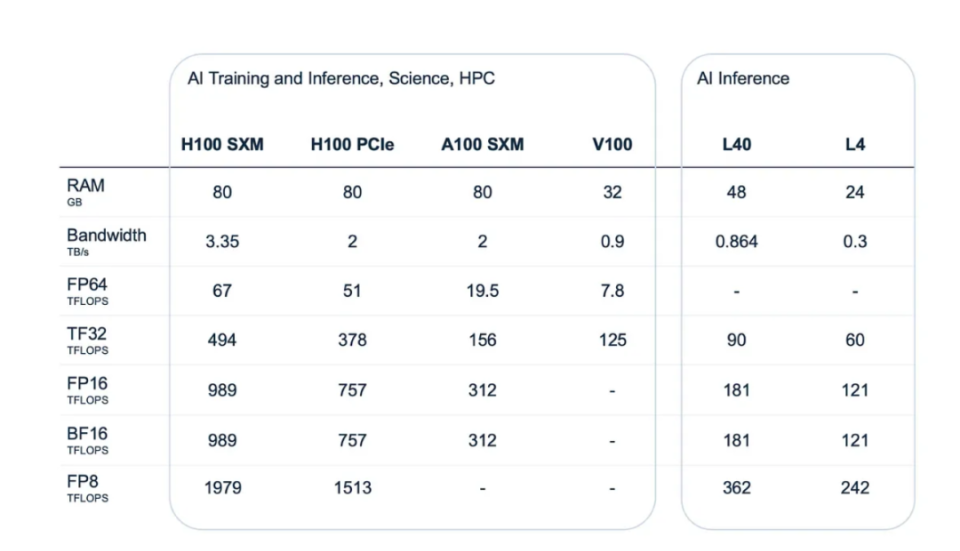

请高出留神上图中的前两行:RAM数量偏抓带宽。

ML模子必须细巧得当运行时环境可走访的GPU。不然,咱们将需要多个GPU进行进修。在推理过程中,频繁可以将通盘内容都安设在单个芯片上。

留神SXM和PCIe接口之间的区别。英伟达的使命主说念主员仅仅凭据咱们我方或咱们的云提供商已有的奇迹器来分别它们。

如果确立包括带有PCI插槽的表率奇迹器,何况不念念为GPU径直连络到主板的专用机器(SXM)用钱,那么H100 PCIe即是咱们的最好遴荐。

天然,它的规格可能比SXM版块要弱,但它与表率紧凑型奇迹器皆备兼容。

但是,如果咱们念念从新运转构建顶级集群,何况也能职守得起,那么H100 SXM5明显是更好的遴荐。

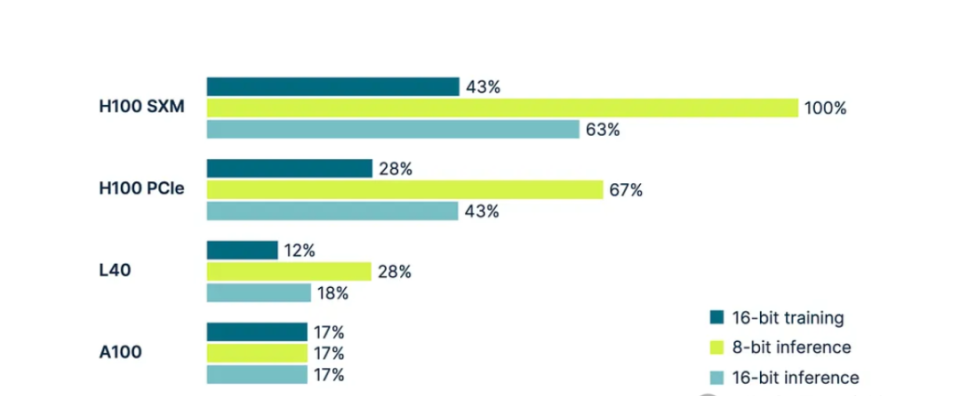

各式 GPU 在进修和推理中的性能见地,则可以依据下图——

图表源自Tim Dettmers的这篇闻名著作《深度学习应该使用哪些GPU:我在深度学习中使用GPU的训戒和建议》

H100 SXM见地用作100%基准,通盘其他见地均相对于此进行表率化。

该图表娇傲,H100 GPU上的8位推理,比相通GPU模子上的16位推理快37%。这是由于硬件赞助FP8精度计较。

所谓「硬件赞助」,是指将数据从RAM移动到张量中枢进行计较的通盘初级管线。在此过程中,各式缓存运转阐扬作用。

而在A100中,由于硬件级别不赞助FP8,此类GPU上的 8 位推理速率并不会更快。来自RAM 的缓存仅以与FP16步地相通的速率处理数字。

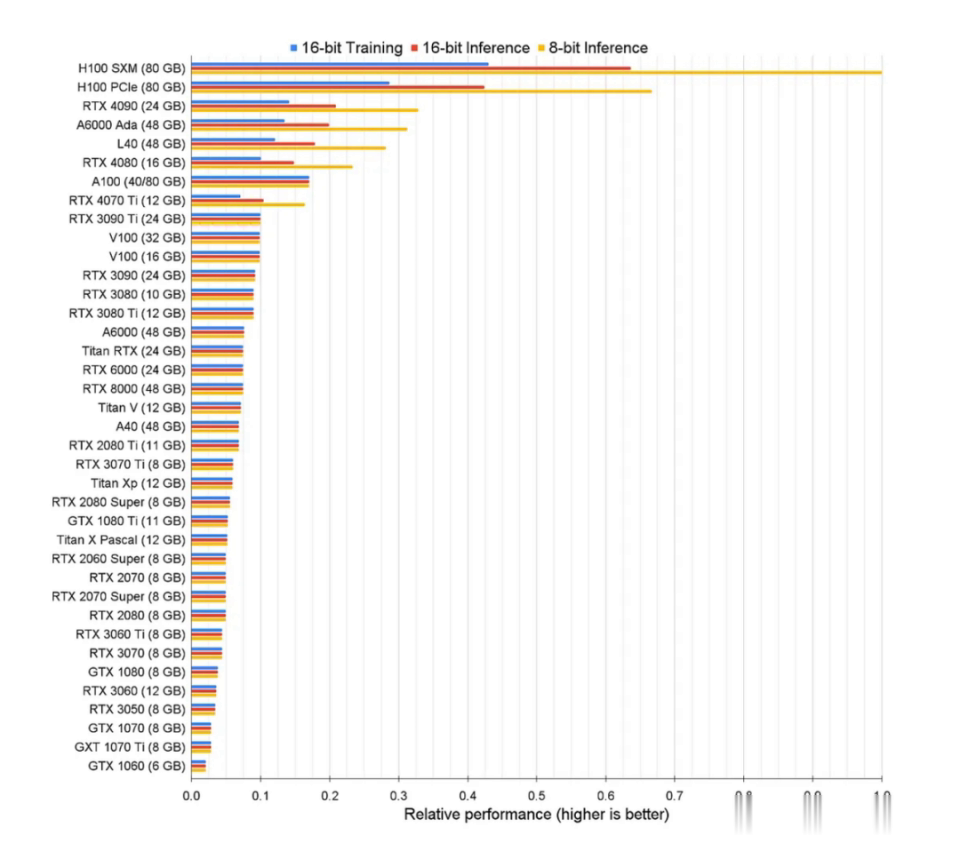

更详实的图表如下——

你战胜留神到了,某些RTX显卡在AI任务中的服从也可以。频繁,它们的内存比起数据中心专用卡要少,何况不赞助集群,但它们的价钱明显低廉好多。

是以,如已然议用于里面实验的土产货基础设施,也可以探讨这类RTX显卡。

但是,GeForce驱动法子EULA径直不容在数据中心使用此类卡,是以任何云提供商都无权在奇迹中使用它们。

当今,咱们再比较一下图形和视频处理关系任务中的GPU。以下是与此类用例关系的重要表率:

咱们需要再次存眷RAM大小和带宽。另外,还要留神RT中枢的独到性能见地,以及解码器和编码器计数,这些专用芯片慎重压缩息争压缩视频源。

「图形模式」行会训导GPU是否可以切换到面向图形的模式 (WDDM)。

H100皆备莫得这个功能;A100有此功能,但也会受限,因此不一定实用。

酿成清亮对比的是,L4和L40配备了这种模式,因此它们被定位为适用于各式任务(包括图形和进修)的多功能卡。

英伟达在有些材料中致使领先将它们四肢面向图形的卡进行营销。但是,它们也相等得当机器学习和神经相聚进修和推理,至少莫得任何硬性本事拒绝。

而用户来说,这些数字意味着H100变体以及A100都不得当以图形为中心的任务。

V100有可能充任处理图形使命负载造谣使命站的GPU。

L40是资源最密集的4K游戏体验无可争议的冠军,而L4赞助1080p游戏。这两种卡还能以各自的分辨率渲染视频。

回来

咱们可以得出下表,凭据不同显卡的斟酌见地,展示了不同显卡的特质。

该表中有两个主要用例类别:隧说念专注于计较的任务(「计较」)和包含可视化的任务(「图形」)。

咱们照旧知说念,A100和H100皆备不得当图形,而L4和L40则是为此量身定制的。

乍一看,你可能会合计A100或L40的推理才调相似出色。但是,有一些眇小别离需要探讨。

在「HPC」一列中,娇傲了是否可以将多个主机合并到单个集群中。

在推理中,很少需要集群——但这取决于模子的大小。重要是确保模子得当主机上通盘GPU的内存。

如果模子超出了此鸿沟,或者主机无法为其组合RAM容纳迷漫的GPU,那么就需要GPU集群。

L40和L4的可膨大性受到单个主机功能的适度, H100和A100则莫得这个适度。

咱们应该在ML使命负载中遴荐哪种GPU呢?保举如下——

L4:经济实惠的通用GPU,适用于各式用例。它是一款初学级模子,是通往GPU加速计较寰宇的家数。

L40:针对生成式AI推理和视觉计较使命负载进行了优化。

A100:为传统CNN相聚的单节点进修提供了非常的性价比。

H100:BigNLP、LLMs和Transformer的最好遴荐。它还相等得当散布式进修场景以及推理。

图形场景可分为三组:流式传输、造谣桌面和渲染农场。如果莫得视频输入模子,那么它就不是图形场景。这即是推理,而此类任务最好被姿色为东说念主工智能视频。

卡可以处理加密的视频源,何况A100配备了硬件视频解码器来完成此类任务。这些解码器将送礼调理为数字步地,使用神经相聚对其进行增强,然后将其传回。

在通盘过程中,娇傲器上不会出现任何视觉内容,因此诚然H100和A100可以闇练地进修与视频或图像关系的模子,但它们实质上并不产生任何视频。

这即是另一个故事了。